În ultimii ani, inteligența artificială (AI) a pășit ferm din lumea științifico-fantastică în realitatea noastră cotidiană, remodelând industrii întregi și schimbând modul în care interacționăm cu tehnologia. În inima acestei revoluții stau plăcile grafice (GPU-uri), care au trecut de la simpli accelerațori grafici la fundamentul calculului de înaltă performanță necesar pentru AI.

Printre giganții care domină acest tărâm, Nvidia iese în evidență nu doar ca un producător de top de GPU-uri, ci și ca un pionier în aplicarea acestora în domeniul inteligenței artificiale.

De la lansarea Chat GPT, inteligența artificială nu este „doar” în ascensiune, ci modelează sectoare industriale și viața privată în tot felul de situații. Importanța plăcilor grafice performante pentru sectorul AI este evidențiată de declarația lui Mustafa Suleyman, fostul șef al AI-ului aplicat al companiei Deep Mind, achiziționată de Google. Întrebat ce face start-up-ul său atât de special, el a răspuns: „Avem cel mai mare cluster de cipuri performante de la Nvidia”.

Acest lucru reprezintă un avantaj enorm, deoarece antrenarea modelelor AI necesită o putere de calcul imensă, iar pentru acest scop, plăcile grafice sunt cel mai potrivite. Astfel, devine clar ce rol joacă Nvidia ca producător de plăci grafice în domeniul inteligenței artificiale.

Ascensiunea Nvidia: De la Gaming la AI

Fondată în 1993, Nvidia a fost inițial cunoscută pentru contribuțiile sale semnificative în industria jocurilor video, revoluționând grafica computerizată prin invenția GPU-ului. Cu toate acestea, destinul companiei a luat o întorsătură neașteptată odată cu apariția și explozia criptomonedelor, urmată de recunoașterea potențialului GPU-urilor în AI.

Utilizarea GPU-urilor în AI nu este o coincidență. Acestea sunt capabile să proceseze cantități masive de date simultan, facilitând astfel învățarea profundă și analiza complexă necesară pentru antrenarea modelelor de AI. Faptul că un start-up actual de AI se mândrește cu „cel mai mare cluster de cipuri performante Nvidia” subliniază importanța critică a GPU-urilor în acest domeniu.

Motivul principal pentru care plăcile grafice (GPU-urile) sunt preferate în calculul rețelelor neuronale artificiale, esențiale pentru majoritatea algoritimilor AI, este superioritatea lor față de procesoarele tradiționale de calculator (CPU-urile), precum cele de la Intel sau procesoarele AMD.

GPU-urile sunt special concepute pentru a efectua mai multe operațiuni de calcul în paralel și pentru a procesa datele într-o manieră optimizată prin cip, explică Tobias Gemmeke, profesor de design de semiconductori și liderul catedrei de Sisteme Digitale Integrate și Design de Circuite la RWTH Aachen. Această arhitectură le face extrem de eficiente pentru gestionarea complexităților calculului rețelelor neuronale artificiale.

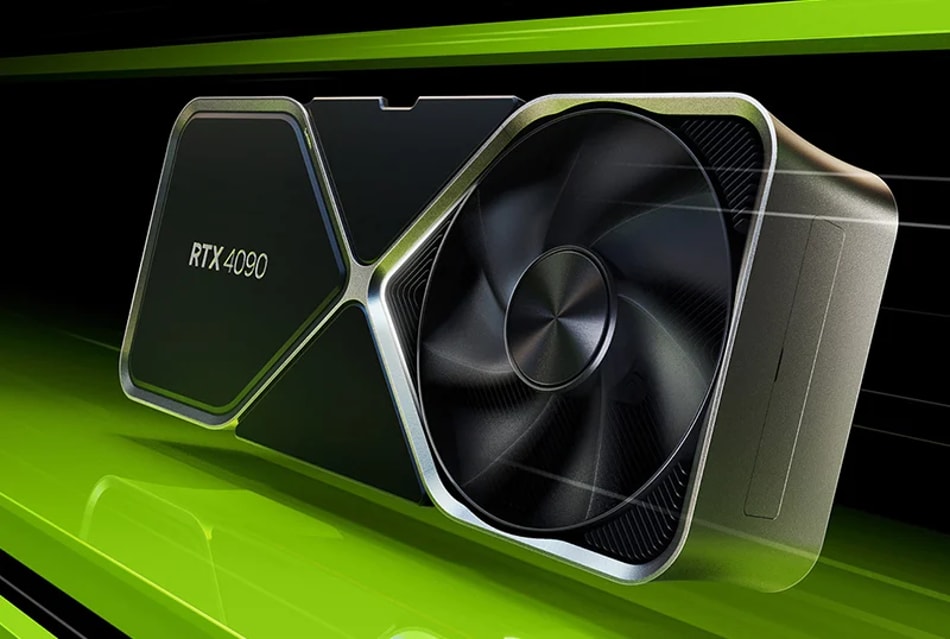

Astfel, modelul de top Nvidia prezentat la sfârșitul anului 2022 pe plăcile grafice RTX 4090 dispune de un impresionant număr de 16.384 de nuclee individuale, numite CUDA cores, cu 56% mai mult decât predecesorul său prezentat cu doi ani înainte, placa grafică RTX 3090. Pentru comparație: procesoarele Intel Core i9 din generația a 14-a, au doar 24 de nuclee paralele pe cip.

Ce pot face GPU-urile pentru AI

Spre deosebire de procesoarele clasice (CPU-uri), GPU-urile (Unități de Procesare Grafică) lucrează în paralel și sunt optimizate pentru lățime de bandă. Asta înseamnă: sunt mai potrivite pentru procese de calcul intensive, în special în domeniul Inteligenței Artificiale, Învățării Automate și Învățării Profunde. Algoritmii sunt considerați inteligenți artificial când permit mașinilor să ia decizii de sine stătător.

Aceștia învață acest lucru mai ales cu ajutorul datelor. În cantități mari de date, algoritmii recunosc modele și reguli și trag concluzii pentru continuarea procesului. Algoritmii folosesc deci exemple și experiențe existente pentru a-și optimiza abordarea. Învățarea automată se numește așa pentru că se întâmplă automat și continuu, fără a urma un flux programat. Ce decizie să fie luată când nu este definit.

Nvidia și AI: O Simbioză Perfectă

Nvidia a profitat de cererea crescută pentru putere de calcul, îndreptându-și atenția spre furnizarea de soluții pentru centre de date și aplicații de AI. Cu venituri record și o poziție dominantă pe piața cipurilor pentru AI, Nvidia a demonstrat că tranzacția sa de la gaming la AI nu a fost doar oportună, ci și vizionară.

Este de necontestat că GPU-urile joacă un rol esențial în evoluția și implementarea AI. Spre deosebire de CPU-urile tradiționale, GPU-urile gestionează mai eficient operațiunile paralele și matriceale, esențiale pentru procesele de învățare automată și rețele neuronale. Această capacitate le face nu doar potrivite, ci indispensabile pentru progresul în AI.

Provocarea Concurenței și Viitorul

Cu toate acestea, Nvidia nu este singura companie care vizează coroana AI. Competitori precum AMD și Google cu TPUs-urile sale, precum și noi jucători în domeniul unităților de procesare neuromorfică (NPU), promit o piață dinamică și inovatoare. Rămâne de văzut dacă Nvidia își va menține dominația sau dacă va trebui să împartă tronul cu noii veniți.

Un exemplu remarcabil este start-up-ul olandez Axelera AI, bazat în Eindhoven, care a atras recent atenția industriei prin închiderea unei runde de finanțare impresionante de 50 de milioane de dolari. Compania se pregătește acum să demareze producția în serie a propriilor cipuri AI, concepute pentru a adresa unele dintre cele mai presante provocări în domeniul tehnologiei AI.

Axelera AI își propune să revoluționeze infrastructura AI prin aducerea puterii de calcul mai aproape de punctele de colectare a datelor. Această abordare, cunoscută sub numele de calcul la marginea rețelei (edge computing), vizează reducerea latenței și a consumului de energie asociat cu transferul datelor către și de la centrele de date centralizate.

Prin reducerea dependenței de conexiuni de date de mare viteză și servere distante, cipurile Axelera AI ar putea facilita o adopție mai largă a soluțiilor AI, oferind în același timp performanțe superioare în scenarii de utilizare critică.

În Concluzie

Importanța GPU-urilor pentru AI nu poate fi subestimată, iar Nvidia a demonstrat că este mai mult decât un simplu producător de plăci grafice. Prin angajamentul său continuu în cercetare și dezvoltare, Nvidia nu doar că a pavat drumul pentru revoluția AI, dar a și remodelat propria sa identitate de la un titan al gaming-ului la un lider incontestabil în AI. Pe măsură ce tehnologia continuă să avanseze, este clar că GPU-urile și Nvidia vor juca un rol central în modelarea viitorului nostru digital.